DeepSeek首次回应“蒸馏OpenAI”质疑...

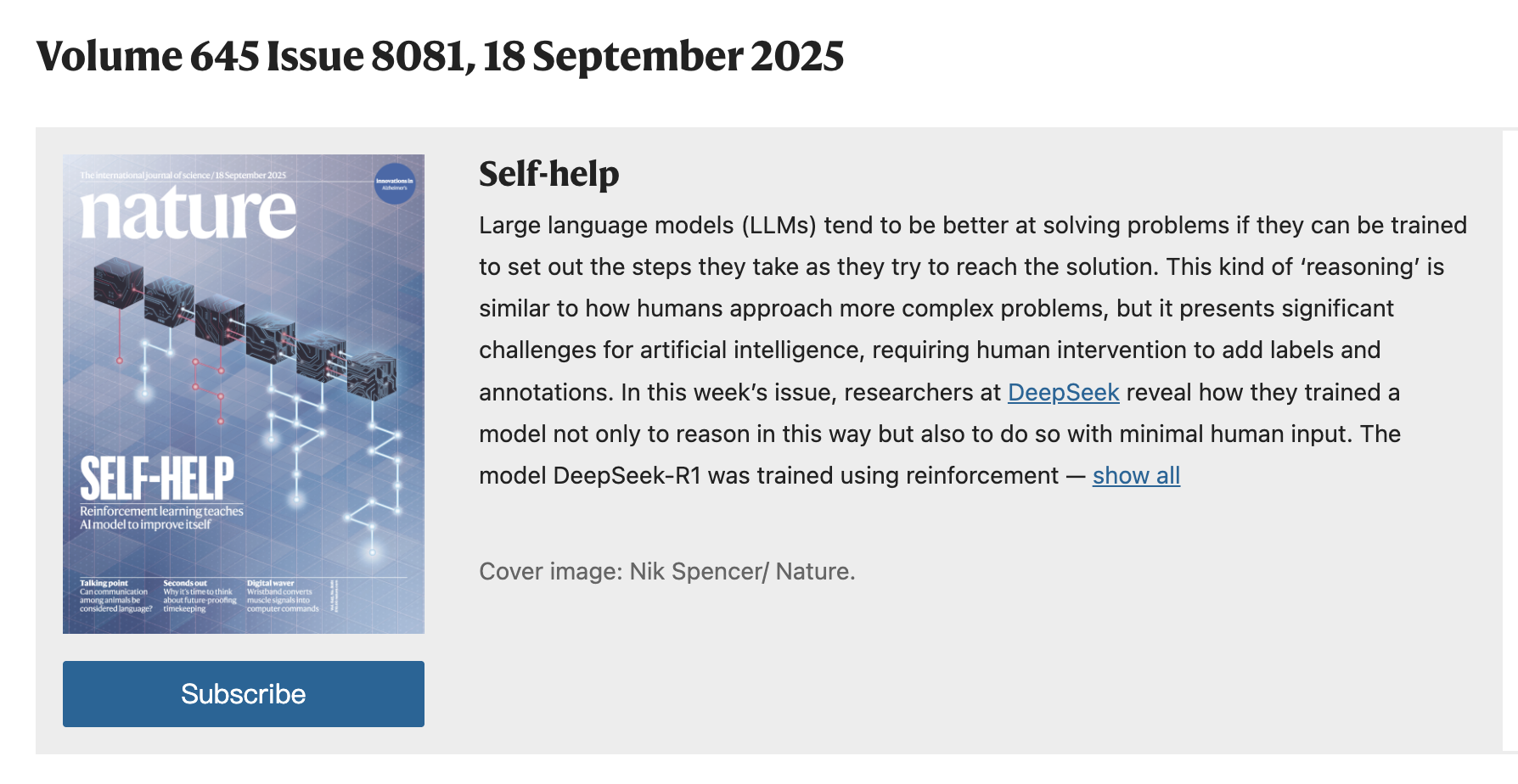

9月18日,DeepSeek再次引发轰动。由DeepSeek团队共同完成、梁文锋担任通讯作者的DeepSeek-R1研究论文,登上了国际权威期刊《Nature》的封面。

以往的研究主要依赖大量监督数据来提升模型性能。DeepSeek的开发团队则开辟了一种全新的思路,即使不用监督微调(SFT)作为冷启动,通过大规模强化学习也能显著提升模型的推理能力。如果再加上少量的冷启动数据,效果会更好。

在强化学习中,模型正确解答数学问题时会获得高分奖励,答错则会受到惩罚。因此模型学会了推理,逐步解决问题并揭示这些步骤,从而更有可能得出正确答案。这使得 DeepSeek-R1 能够自我验证和自我反思,在给出新问题的答案之前检查其性能,从而提高其在编程和研究生水平科学问题上的表现。

DeepSeek在模型训练中,采用了群组相对策略优化(GRPO)来降低训练成本,设计奖励机制决定着强化学习优化的方向,同时团队设计了简单模板来引导基础模型,要求模型先给出推理过程,再提供最终答案。

为了使更高效的小模型具备 DeepSeek-R1 那样的推理能力,开发团队还直接使用 DeepSeek-R1 整理的 80 万个样本对 Qwen 和 Llama 等开源模型进行了微调。研究结果表明,这种简单的蒸馏方法显著增强了小模型的推理能力。

以下内容为友情赞助提供

全网新项目分享交流群

扫码进群,获取最新项目资讯

文档于: 2025-09-18 12:33 修改

标签:

评论列表

DeepSeek首次回应“蒸馏OpenAI”质疑...

9月18日,DeepSeek再次引发轰动。由DeepSeek团队共同完成、梁文锋担任通讯作者的DeepSeek-R1研究论文,登上了国际权威期刊《Nature》的封面。今年1月,DeepSeek曾在arxiv公布了初版预印本论文,相较而言,...